Revolutionierung der Chatbot-Technologie: Wie Enterprise Bot RAG für GenAI-Anwendungen nutzt

Das RAG-gesteuerte Framework von Enterprise Bot revolutioniert GenAI, indem es die LLM-Beschränkungen für Unternehmen überwindet.

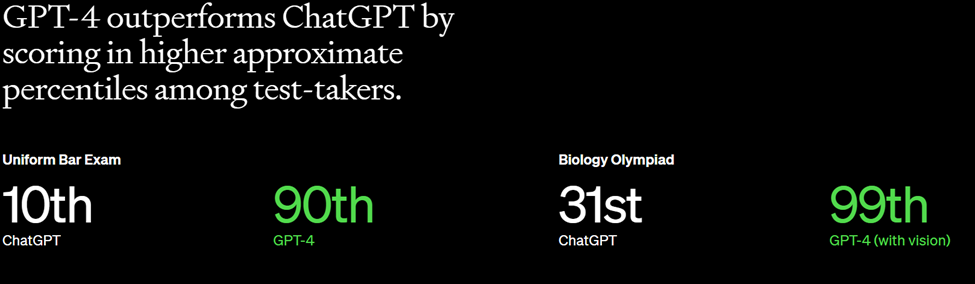

Die Integration von Large Language Models (LLMs) wie ChatGPT von OpenAI und Claude von Anthropic in Unternehmensanwendungen hat ein immenses Potenzial gezeigt, wenn auch mit gewissen Einschränkungen wie statischen Daten, fehlendem Fachwissen und der Blackbox-Natur von LLMs. Um diese Herausforderungen anzugehen, hat sich eine neue Methode, Retrieval Augmented Generation (RAG), als praktikable Lösung herauskristallisiert.

Das architektonische Framework von Enterprise Bot nutzt RAG, um die Fähigkeiten von LLMs zu verbessern und eine effiziente Datenerfassung und Antwortgenerierung aus verschiedenen Unternehmensdatenquellen wie Confluence und SharePoint sicherzustellen. Dieses Dokument erläutert die Architektur, den Datenfluss und die Vorteile des Einsatzes von RAG durch die Lösung von Enterprise Bot zur Erweiterung von GenAI-Anwendungen.

RAG liefert kontext- und branchenspezifische Daten für Ihre GenAI Unternehmensanwendung

bnEnterprise Bot ist eine führende KI-Lösung für Omnichannel-Konversationen, die personalisierte virtuelle Assistenten auf der Grundlage von GenAI und Prozessautomatisierung auf der Basis eines Large Language Model wie ChatGPT bereitstellt, um das Kunden- und Mitarbeitererlebnis zu revolutionieren.

Die Architektur von Enterprise Bot ist sorgfältig darauf ausgelegt, RAG-Prozesse zu optimieren und so die Lücke zwischen statischen LLMs und dynamischer, kontextbezogener Antwortgenerierung zu schließen.

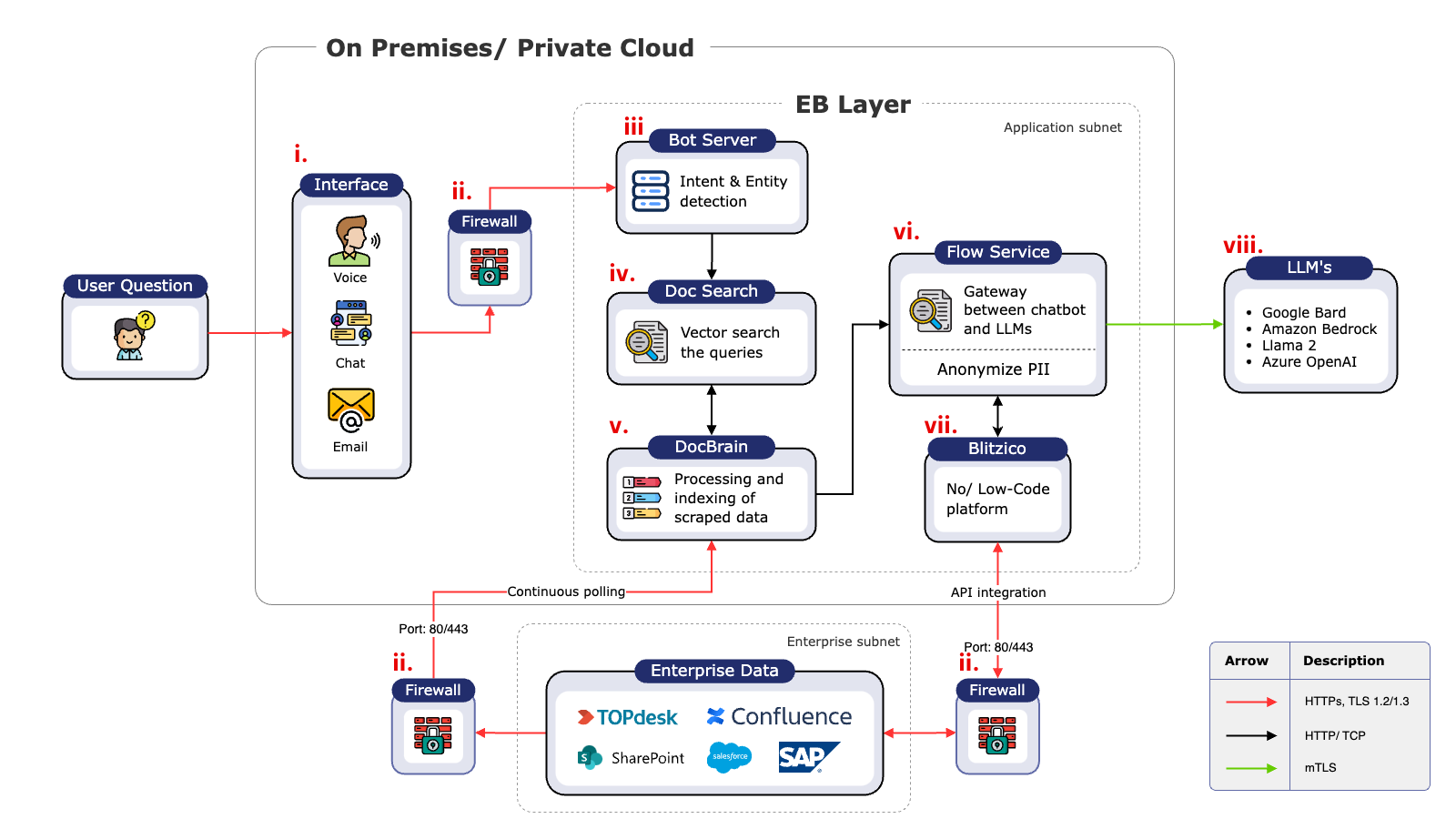

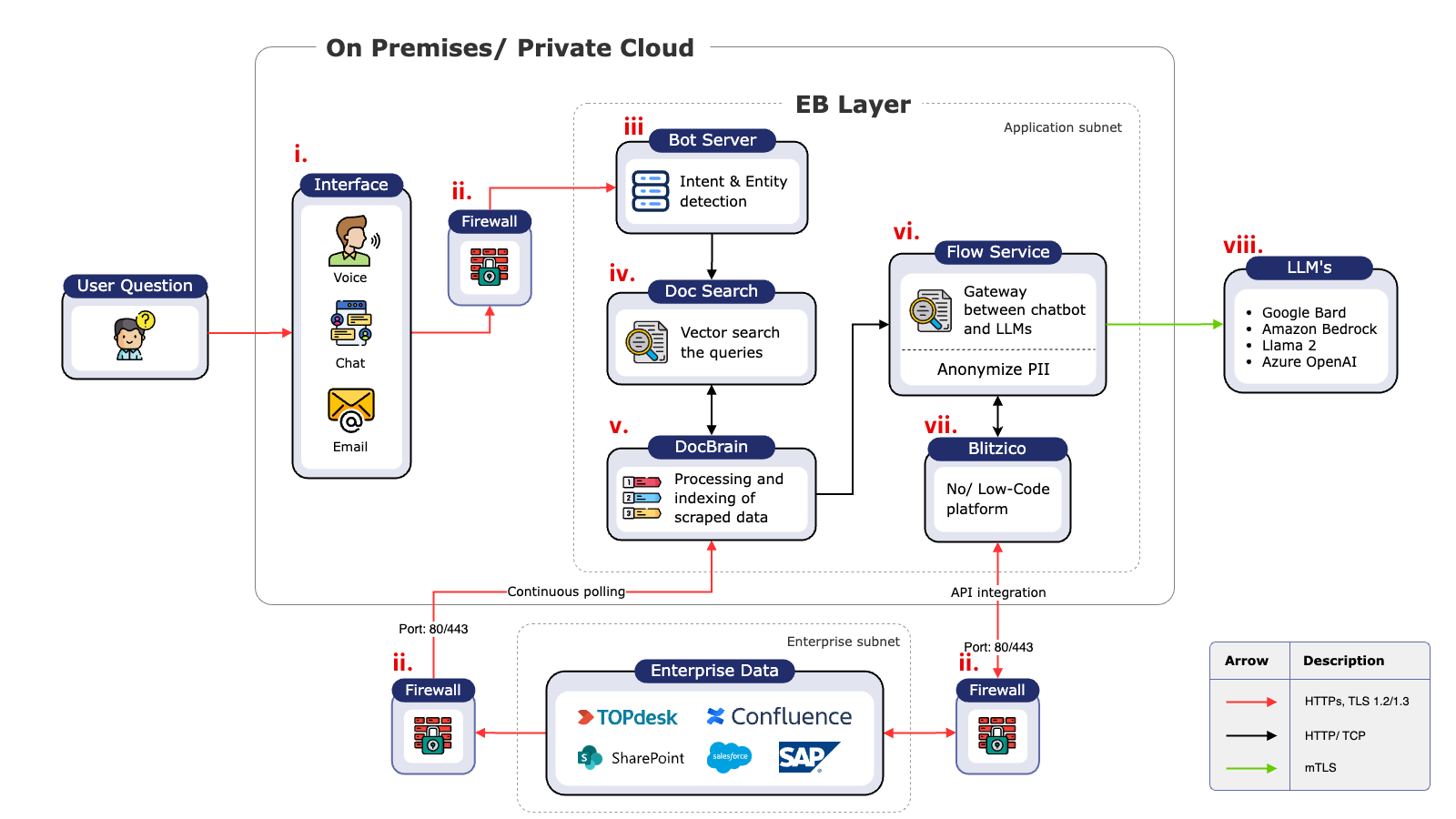

Enterprise Bot's Architektur Übersicht

Beschreibung der Komponenten:

i. Interface: Der erste Punkt der Interaktion, an dem Benutzer ihre Anfragen eingeben, sei es per Chat, E-Mail, Dokumente oder Anrufe.

ii. Firewall: Sorgt für autorisierten Datenverkehr und schützt das System vor unberechtigtem Zugriff und potenziellen Sicherheitsbedrohungen.

iii. Bot Server: Analysiert Benutzeranfragen auf Intent,- und Entity-Erkennung und bestimmt den nachfolgenden Workflow.

iv. DocSearch: Eine hybride und semantische Suchmaschine, die Benutzeranfragen in Suchvektoren umwandelt und relevante Daten von DocBrain abruft.

v. DocBrain: Nimmt Daten aus verschiedenen Quellen auf und aktualisiert diese, um sicherzustellen, dass die Inhalte aktuell und korrekt bleiben.

vi. Flow Service: Funktioniert als RAG-Pipeline und als Tor zu den LLMs und sorgt für einen reibungslosen Informationsfluss.

vii. Blitzico: Eine Plattform mit wenig/keinem Code zur Ergänzung von Informationen oder zur Ausführung von Aufgaben über APIs in verschiedenen Systemen oder RPAs nach Bedarf.

viii. LLM: Die Large Language Models wie ChatGPT, Azure OpenAI, Llama2 usw., die Antworten auf der Grundlage der eingegebenen Prompts generieren.

ix. Training/Validierung: Speichert alle Daten zur Analyse, Korrektur und Feinabstimmung des Modells, um das System im Laufe der Zeit zu verbessern.

Enterprise Bot nutzt den RAG-Vorteil, um Kontextbewusstsein, Genauigkeit und Nachvollziehbarkeit zu gewährleisten

Enterprise Bot verwendet RAG in der Architektur, um die Einschränkungen von LLMs zu überwinden, indem wir aktuelle oder kontextspezifische Daten aus Unternehmensdatenquellen abrufen und sie den LLMs während der Antwortgenerierung zur Verfügung stellen.

Die Vorteile beinhalten:

a. Aktuelle Informationen: RAG stellt sicher, dass LLMs Zugang zu den aktuellsten Daten haben, indem es eine Schnittstelle zu Vektordatenbanken mit fachspezifischen proprietären Daten herstellt.

b. Fachspezifischer Kontext: Bietet LLMs die dringend benötigten fachspezifischen Informationen und verbessert so die Genauigkeit und Relevanz der generierten Antworten.

c. Reduzierte Halluzinationen: RAG verhindert, dass falsche oder erfundene Informationen von LLMs aufgrund von fehlendem Kontext oder veralteten Daten erzeugt werden.

d. Prüfbarkeit: RAG ermöglicht es GenAI-Anwendungen, Quellen zu zitieren, so dass der Prozess transparent und leichter zu überprüfen ist.

RAG ist kostengünstiger als andere Konzepte

Die RAG-gesteuerte Enterprise Bot-Lösung bietet einen kostengünstigen Ansatz im Vergleich zu Alternativen wie der Erstellung eines neuen Basismodells oder dem Fine-Tuning bestehender Modelle. Mit Hilfe der semantischen Suche wird relevanter Kontext abgerufen, so dass weniger umfangreiche Datenbeschriftungen, ständige Qualitätsüberwachung und wiederholtes Fine-Tuning erforderlich sind.

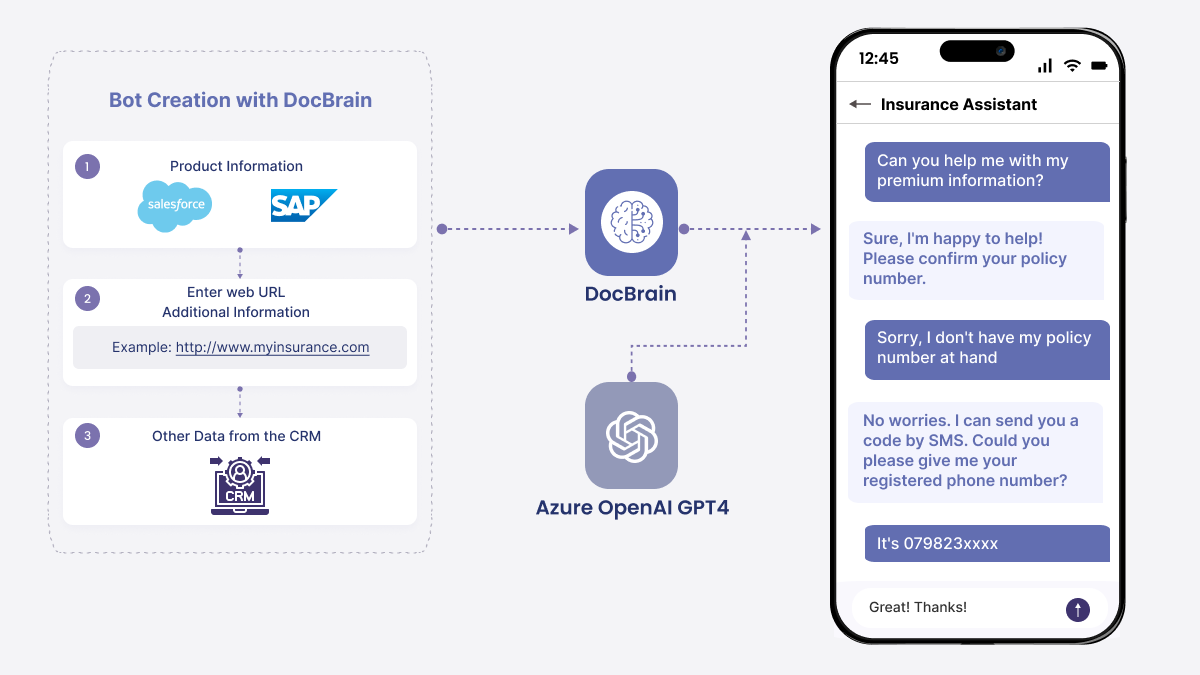

Darüber hinaus revolutioniert die zum Patent angemeldete Technologie von Enterprise Bot, DocBrain, den derzeitigen absichtsbasierten Ansatz der Conversational AI-Branche. Herkömmliche Plattformen erfordern ein umfangreiches Training mit über 200 Intentionen und mindestens 50 Beispielen, oft verbunden mit der Nachbildung bereits bestehender Website-FAQs. DocBrain überwindet dies, indem es selbstständig Wissensgraphen und Omnichannel-Bots aus Informationsquellen wie Websites, PDFs, Confluence, TopDesk und anderen Repositories erstellt. Dies bedeutet, dass Antworten ohne manuelle Absichtserklärung verarbeitet werden, was die Markteinführungszeit um 80 % verkürzt. Darüber hinaus aktualisiert sich das System selbst auf der Grundlage von Website- oder Dokumentenänderungen, wodurch der Wartungsaufwand minimiert wird und eine Neuerstellung des CMS überflüssig ist.

Entschlüsselung von Conversational AI-Schnittstellen: Wie Vektordatenbanken die semantische Suche mit natürlichsprachlichen Abfragen unterstützen

Durch den Einsatz von semantischer Suche und Vektordatenbanken ermöglicht Enterprise Bot ein tieferes Verständnis von Benutzeranfragen, was genauere und kontextuell relevante Antworten ermöglicht. Dieser Prozess umfasst die Umwandlung von domänenspezifischen Daten in Vektoren mithilfe eines Einbettungsmodells, das Speichern dieser Vektoren in einer Datenbank wie Pinecone und das Durchführen semantischer Suchen, um die relevantesten Daten abzurufen.

Revolutionierung von GenAI: Das RAG-gesteuerte Framework von Enterprise Bot überwindet die Einschränkungen von LLMs für Unternehmen

Enterprise Bot bietet mit seiner RAG-gesteuerten Architektur eine robuste Lösung für die Einschränkungen aktueller LLMs und macht GenAI-Anwendungen genauer, effizienter und kostengünstiger. Durch die kontinuierliche Aktualisierung unserer Datenbank und die Bereitstellung von domänenspezifischem Kontext für LLMs verbessern wir die Leistung und Zuverlässigkeit von GenAI-Anwendungen im Unternehmensumfeld erheblich.

SErleben Sie die Zukunft des Kunden- und Mitarbeitererlebnisses mit der Omnichannel-Lösung von Enterprise Bot, die unabhängig von LLM ist.

Entdecken Sie, wie unsere fortschrittliche Konversations-KI und Prozessautomatisierung, einschließlich der bahnbrechenden DocBrain-Technologie, Ihre Kundeninteraktionen verbessern, Serviceprozesse rationalisieren und ein noch nie dagewesenes Maß an Kundenzufriedenheit erreichen kann. Es ist an der Zeit, den Kundenservice in die Zukunft zu führen - in Ihre Zukunft. Buchen Sie jetzt eine Demo. Ihre Reise zu einem durch KI verbesserten Kundenkontakt beginnt hier, mit Enterprise Bot. Warten Sie nicht - nutzen Sie den KI-Vorteil noch heute!